机构名称:

¥ 2.0

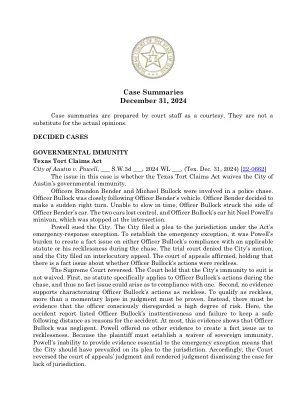

十多年来,已经进行了广泛的研究工作,即如何有效利用复发模型和注意力。重复模型旨在将数据压缩到固定大小的内存(称为隐藏状态)中,但注意力允许参与整个上下文窗口,从而捕获所有令牌的直接依赖性。然而,这种更准确的依赖性建模带有二次成本,将模型限制在固定长度上下文中。我们提出了一个新的神经长期记忆模块,该模块学会记住历史上下文,并有助于关注当前的环境,同时使用长期过去的信息。我们表明,这种神经记忆具有快速平行训练的优势,同时保持快速推断。从内存的角度来看,我们认为,由于其有限的上下文而引起的注意力,但准确的依赖性建模作为短期内存,而神经记忆由于记忆数据的能力而引起的,它是长期,更持久的记忆。基于这两个模块,我们介绍了一个新的架构系列,称为Titans,并提出了三个变体,以解决如何有效地将内存纳入该体系结构。我们对语言建模,常识性推理,基因组学和时间序列任务的实验结果表明,泰坦比变形金刚和最近的现代线性复发模型更有效。与基线相比,它们可以有效地扩展到大于2M上下文窗口尺寸,并具有更高的准确性。

arxiv:2501.00663v1 [cs.lg] 2024年12月31日

主要关键词

![arxiv:2501.00663v1 [cs.lg] 2024年12月31日PDF文件第1页](/bimg/4/442769655cee218eeb5b40ce8e2907d54dd0692e.webp)

![arxiv:2501.00663v1 [cs.lg] 2024年12月31日PDF文件第2页](/bimg/8/88d11abceaafdf70ff043fc8be53fd1e721b1c8b.webp)

![arxiv:2501.00663v1 [cs.lg] 2024年12月31日PDF文件第3页](/bimg/5/513f35bc9c22dd921e9ae56b0827e2fb13778861.webp)

![arxiv:2501.00663v1 [cs.lg] 2024年12月31日PDF文件第4页](/bimg/0/0bb4e32e1cfb4dc1cd5a67a404e9897459ac98c7.webp)

![arxiv:2501.00663v1 [cs.lg] 2024年12月31日PDF文件第5页](/bimg/6/6b4e36bbd983b7ac81cd177f3fc551cb206de507.webp)

![arxiv:2501.00663v1 [cs.lg] 2024年12月31日](/simg/0/0b8b490ba3726d6a15941c8349f71d476a9f7fd9.webp)

![arxiv:2407.16928v2 [cs.cr] 2024年12月31日](/simg/8/86eac3ad6bbce5b61e71a23f0e90f56f2598fb7a.webp)

![arxiv:2303.16900V2 [CS.CV] 2024年12月31日](/simg/7/7fbd38e5186adbb4127c602f7882076c73aa6525.webp)

![arxiv:2407.21654v1 [cs.cv] 2024年7月31日](/simg/e/eea76ff78a5e1b25306a95443ed7ef0f1c6b852c.webp)

![arxiv:2409.09541v3 [cs.ai] 2024年12月12日](/simg/1/14209d226327b5a6cbf8e094be8901d23e4dc34a.webp)